엔비디아가 블랙웰 울트라·루빈에 이어 2028년 ‘파인만’ 인공지능(AI) 칩셋을 선보인다. 격년 주기로 새 칩셋과 고대역폭메모리(HBM) 고용량화를 반복하며 AI 시장 패권을 이어가겠다는 의지다. 2027년 출시할 루빈 울트라부터는 현 블랙웰 대비 5배 이상인 1TB(테라바이트)에 달하는 차세대 HBM이 탑재될 예정이다. SK하이닉스와 삼성전자 등 국내 메모리업계에 장기적인 기회의 문이 열렸다는 평가가 따른다.

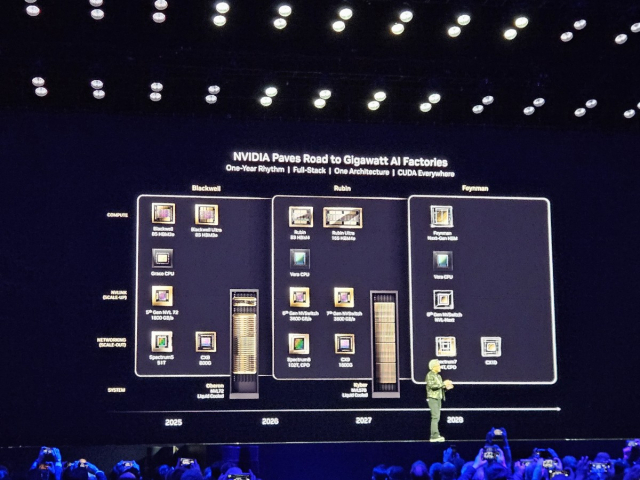

18일(현지 시간) 엔비디아는 미 산호세 SAP센터에서 연례 최대 개발자 행사 ‘GTC 2025’를 열고 2028년까지 제품 로드맵을 소개했다. 올해부터 매년 하반기 각각 블랙웰 울트라, 루빈, 루빈 울트라, 파인만을 선보이겠다는 계획이다. 젠슨 황 엔비디아 최고경영자(CEO)는 “AI 공장(데이터센터) 기준 성능으로 H100 ‘호퍼’ 대비 블랙웰은 68배, 루빈은 900배가 될 것”이라며 “동 성능 대비 가격으로 따지면 호퍼 대비 블랙웰은 13%, 루빈은 3%에 불과하다”고 강조했다.

엔비디아는 격년 주기로 새 칩셋 설계(아키텍쳐)를 내놓고 신형 칩셋이 나온 다음해에는 HBM 용량을 늘려 간다는 전략을 제시했다. 격년 주기로 한 해는 새 설계를, 한 해는 개선판을 내놓는 전통적인 반도체 업계의 ‘틱톡’ 전략이 공정이 아닌 메모리로 재현되는 셈이다. 황 CEO는 “메모리를 높이는 쉬운 전환으로 성능을 쉽게 끌어올릴 수 있다”고 설명했다.

올 하반기에는 지난해 공개했던 블랙웰의 개선판인 블랙웰 울트라가 출하된다. 이는 지난해 컴퓨텍스 2024에서 공개된 사안이다. 블랙웰 울트라는 기존 192GB던 HBM3E를 288GB로 50% 늘렸다.

지난해 GTC 2024에서 소개했던 차세대 칩셋 루빈은 2026년 하반기 선보인다. HBM4를 288GB 탑재해 초당 13TB(테라바이트) 대역폭을 구현한다. 루빈부터는 GPU를 한 데 묶어 하나의 서버 랙으로 엮어낸 ‘NVL’ 플랫폼 내 GPU가 현 블랙웰의 2배인 144개 들어가 동일 서버 당 성능이 대폭 늘어날 예정이다. 황 CEO는 “루빈 NVL144은 블랙웰 울트라 NVL72 대비 3.3배 성능을 낸다”고 강조했다.

2027년에는 루빈에 HBM4E 메모리 1TB를 탑재한 ‘루빈 울트라’가 등장할 예정이다. 루빈 울트라는 한 서버 당 576개 GPU가 탑재된 ‘NVL576’을 구현해 올 하반기 내놓을 블랙웰 울트라 NVL72 대비 14배 속도를 구현한다는 목표다.

루빈 이후에는 신형 설계를 적용한 파인만이 대기 중이다. 이날 황 CEO는 파인만에 대해 코드명만을 소개했을 뿐 구체적인 사항을 공개하지는 않았으나 HBM4E의 다음 세대 HBM이 적용되고 칩셋 내부 대역폭 또한 초당 3600GB가 목표인 루빈을 뛰어넘는다고 한다.

이날 황 CEO는 칩셋 자체 성능 개선보다 연결성·효율성 강화에 더욱 신경쓰는 모습을 보였다. 데이터센터 내 GPU 비중이 빠르게 상승하며 각 GPU간 통신 속도와 효율을 개선하는 것만으로도 현재의 비효율을 덜어낼 수 있다는 판단에서다.

이에 엔비디아는 TSMC와 함께 세계 최초로 실리콘포토닉스를 상용화한 ‘스펙트럼-X’를 올 하반기 내놓겠다고 밝혔다. 실리콘포토닉스는 전자로 이뤄지던 컴퓨터 간 통신을 광자로 대체해 전송 속도를 높이는 한편 전력 소모는 줄이는 기술이다.

AI 연산 단위인 토큰 생성과 분배 과정의 비효율 개선에도 나섰다. 현 GPU는 더 많은 사용자들에게 토큰을 제공할수록 총 토큰 생산속도가 느려진다. 자원 분배 과정에서 연산에 비효율이 발생하는 탓이다. 여기에 추론 AI가 대세화하며 연산 과정이 더욱 복잡해짐에 따라 토큰 분배의 ‘최적점’을 찾기가 더욱 어려워지고 있다.

이에 엔비디아는 추론 AI 전용 소프트웨어 라이브러리 ‘다이나모’를 공개했다. 현재 엔비디아의 성공을 이끌었다는 평가를 받는 쿠다(CUDA) 처럼 오픈소스로 개발해 AI 생태계 장악력을 강화하겠다는 각오다. 황 CEO는 “추론 AI는 일반 AI 대비 연산량이 100배 이상 필요하다"며 "다이나모를 적용하면 100MW 전력을 사용하는 데이터센터 당 블랙웰의 최적 토큰 생산량을 H100 호퍼 대비 40배로 끌어올릴 수 있다”고 했다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

beherenow@sedaily.com

beherenow@sedaily.com