아마존웹서비스(AWS)는 자사 솔루션을 기반으로 LG AI연구원이 이미지를 입력하면 텍스트로 변환하는 ‘이미지 투 텍스트’ 캡셔닝 솔루션을 출시했다고 30일 발표했다.

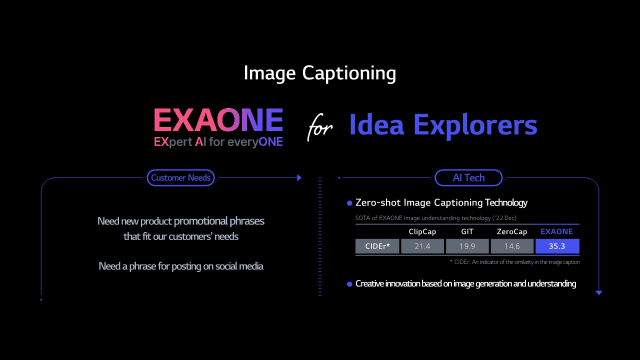

이 솔루션은 3000억 개의 매개변수를 보유한 LG AI연구원의 멀티모달 파운데이션 모델인 엑사원(EXAONE)을 기반으로 한다. 엑사원은 광고, 패션, 리테일 등 다양한 산업 분야의 전 세계 고객을 위해 보다 정확하고 관련성 높은 콘텐츠를 위한 캡셔닝 솔루션을 제공하고 있다.

엑사원의 새로운 제로샷 이미지 캡션 솔루션은 생성형 AI를 사용해 인간의 인지 능력과 유사하게, 이전의 경험과 지식, 훈련을 바탕으로 본 적 없는 객체나 장면을 자동으로 이해하고 설명한다. 이로써 한국어와 영어로 된 이미지와 텍스트를 이해하고 인간에 가까운 추론 능력을 활용해 정확하고 상세한 이미지 캡션과 키워드를 작성할 수 있다. 광고와 같은 산업군에서는 LG AI연구원의 기술을 활용해 제품 설명을 자동화하거나 광고·마케팅 캠페인을 위한 새로운 콘텐츠를 만들 수 있다.

LG AI연구원은 엑사원을 고도화하는 과정에서 정보기술(IT) 자원이 더 필요한 경우 등 다양한 변수에 대비하기 위해 컴퓨팅 용량을 클라우드를 통해 언제든 조정할 수 있는 아마존 엘라스틱 컴퓨트 클라우드(Amazon EC2)를 사용했다.

또 LG AI연구원은 머신러닝(ML) 모델을 구축·훈련·배포하는 완전 관리형 서비스 아마존 세이지메이커(Amazon SageMaker)도 사용해 3억 5000만 개의 고해상도 이미지와 텍스트 셋을 엑사원에게 학습시켰다. LG AI연구원은 클라우드를 사용해 서버 자원을 직접 구축하는 것보다 더 빠르고 저렴한 비용으로 모델을 고도화하며 데이터 편향과 같은 문제를 신속하게 해결할 수 있었다고 설명했다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

hjin@sedaily.com

hjin@sedaily.com