네이버의 대화형 인공지능(AI) 클로바X가 시각 정보도 동시에 처리할 수 있는 '멀티모달'(복합정보처리) AI로 진화한다. 거대 언어모델(LLM) 하이퍼클로바X를 선보인 지 약 1년만이다. 추후 음성으로 대화할 수 있는 기능도 탑재할 예정이다.

네이버는 이달 27일 클로바X에 멀티모달 거대 언어모델 ‘하이퍼클로바X 비전’을 탑재해 시각 정보 처리 능력을 새롭게 추가한다고 22일 밝혔다. 하이퍼클로바X 기반의 기업간거래(B2B) 클라우드 솔루션 ‘클로바 스튜디오’에도 도입된다.

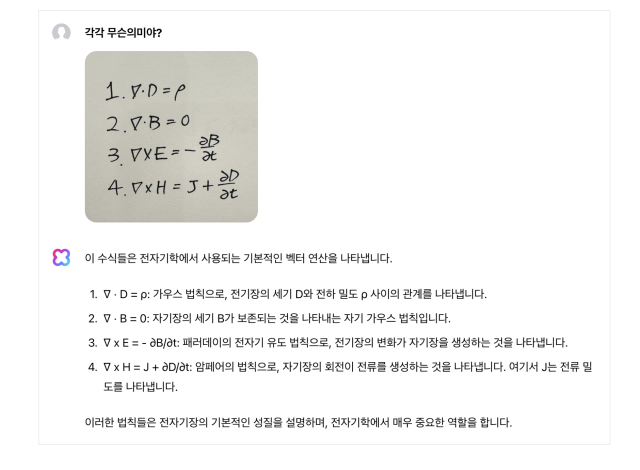

사용자들은 이번 업데이트로 클로바X 대화창에 올린 이미지에서 추출된 정보와 입력한 질의를 바탕으로 AI와 대화할 수 있다.

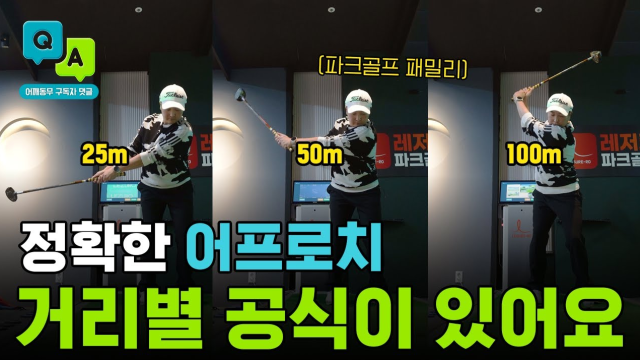

클로바X는 사진 속 현상을 묘사하거나 상황을 추론하는 등 다양한 지시를 수행할 수 있다. 예를 들어 클로바X가 이미지나 그림 형식으로 된 표, 그래프를 이해하고 분석하는 것이 가능하다.

클로바X는 그동안 논리적 글쓰기, 코드 작성, 번역 등의 작업에 사용됐는데 이미지 이해 능력을 기반으로 개인의 생산성 향상 도구로서 활용 범위가 넓어졌다. 네이버는 하이퍼클로바X 비전의 성능이 오픈AI의 GPT-4v 수준이라고 설명했다. 네이버에 따르면 하이퍼클로바X 비전의 MMMU 등 8개 지표 평균 점수는 71.59점으로 GPT-4V(71.63) 대비 0.04점 낮다.

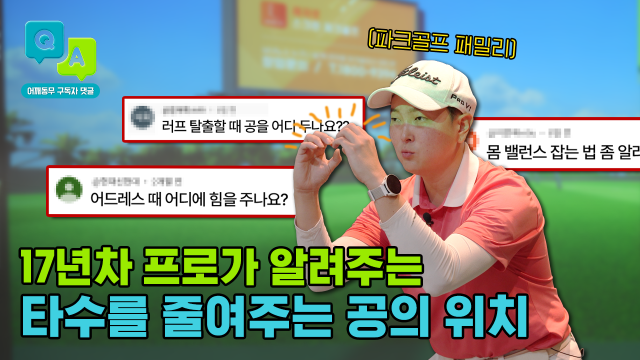

한국 지역의 문화와 가치를 보다 강력하게 반영했다는 ‘소버린 AI’로서 강점도 살렸다. 실제 대한민국 초·중·고등학교 검정고시 총 1480개 문항을 AI 모델에 이미지 형태로 입력하고 문제를 풀게 한 결과, 클로바X는 약 84%의 정답률을 기록해 오픈AI의 GPT-4o(GPT-포오)의 78%보다 높은 정답률을 보였다.

네이버는 하이퍼클로바X 기반 음성 AI 기술 ‘오디오 LLM’도 공개했다. 오디오 LLM은 기존의 음성 인식, 음성 합성 기술보다 발전한 모델로 언어 구조 및 발음 정확도 개선은 물론, 감정 표현까지 더한 자연스러운 대화가 가능하다. 네이버는 실시간 음성 번역, 언어 학습, 상담 등 이 기술의 다양한 서비스 가능성을 제시했다.

성낙호 네이버클라우드 하이퍼스케일(Hyperscale·초대형) AI 기술 총괄은 "거대언어모델로 출발한 하이퍼클로바X는 이미지 이해 능력을 더한 거대시각언어모델, 나아가 음성 멀티모달 언어모델로 발전하고 있다"고 말했다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

kim@sedaily.com

kim@sedaily.com