구글이 전 세대보다 10배 빨라진 추론 최적화 인공지능(AI) 가속기 ‘아이언우드’로 AI 클라우드 시장 입지 강화에 나선다. 자체 칩에 구글 서비스용 인프라를 동원해 경제성을 확보한다는 전략이다. 이를 통해 생성형 AI ‘제미나이’ 가성비를 딥시크 이상으로 끌어 높여 클라우드 기업간거래(B2B) 시장을 공략한다는 구상이다. 구글은 ‘아이언우드’ 고대역폭메모리(HBM) 탑재량을 6배 늘리는 한편, 가정용 로봇 ‘볼리’에 제미나이를 이식해 피지컬 AI 시대 삼성전자(005930)와의 긴밀한 공조도 예고했다.

구글 클라우드는 9일(현지 시간) 미 라스베이거스에서 개막한 ‘구글 클라우드 넥스트 2025’에서 7세대 텐서처리장치(TPU) 아이언우드, 제미나이 2.5 플래시, 클라우드 광역네트워크(WAN)를 비롯한 ‘AI 클라우드’ 전략을 공개했다.

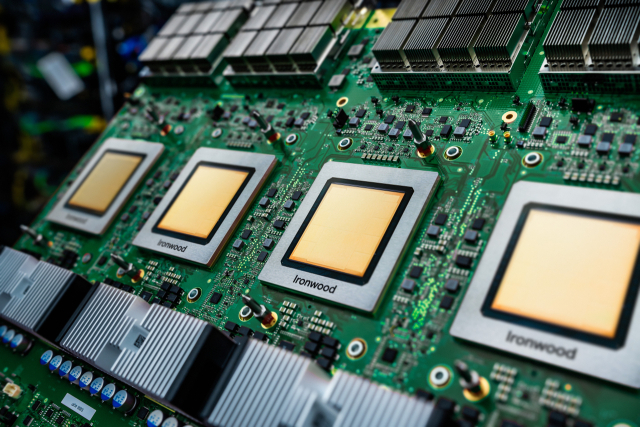

아이언우드는 전 세대인 ‘트릴리움’ 대비 총 성능이 10배 개선됐다. 트릴리움의 성능 개선폭이 4.7배였다는 점에 미뤄볼 때 급속한 발전이다. 전력 대 성능비 또한 1년새 2배 개선돼, 2018년 선보였던 1세대 TPU보다 30배 높아졌다는 설명이다. HBM3E가 192GB(기가바이트)로 6배 늘어난 점이 성능 향상의 원동력이다. 삼성전자·SK하이닉스 등 국내 메모리업계에도 기회로 작용할 전망이다. 반도체 업계는 올해 구글이 HBM 구매를 2배 이상 늘려 엔비디아에 이은 두번째 수요처로 떠오를 것으로 기대하고 있다.

과거 TPU는 애매한 성능과 범용성 탓에 구글 내부용에 그친다는 비판을 받았다. 아이언우드는 엔비디아 H100을 넘어서는 4614테라플롭스(TFLOPS·초당 1조회 연산)의 속도를 자랑한다. 또 최대 9216개 칩을 엮어 제공할 땐 42.5엑사플롭스(EFLOPS·초당 100경회 연산)에 달하는 연산력으로 세계 최대 슈퍼컴 ‘엘 카피탄’보다 24배 빠르다. AWS, MS 등 주요 클라우드 업체들이 추진 중인 자체 칩 기반 ‘탈(脫) 엔비디아’ 전략에서 구글이 유의미한 성과를 낸 셈이다.

클라우드 ‘원가’인 AI 칩셋 비용 감소는 곧 AI 가성비 향상으로 이어진다. 여기에다 글로벌 200여 개 지역에 산재해 구글 서비스를 지원하는 네트워크망이 ‘클라우드 WAN’이라는 이름으로 제공된다. 이를 통해 네트워크 비용은 40% 줄이고 속도는 40% 높일 수 있다. 토마스 쿠리안 구글 클라우드 최고경영자(CEO)는 “글로벌 수십억 사용자가 이용하는 구글 네트워크가 제로에 가까운 지연 시간으로 제공된다”며 “구글 클라우드에서 구동되는 제미나이 2.0 플래시는 오픈AI GPT-4o의 24배, 딥시크 R1보다 5배 높은 가성비를 낼 것”이라고 강조했다.

생성형 AI의 미래로 주목 받는 ‘피지컬 AI’에 대한 비전도 제시했다. 삼성전자가 올 상반기 중 출시할 예정인 가정용 로봇 ‘볼리’에 구글 제미나이가 탑재된다. 제미나이 라이브의 자연스러운 음성 대화뿐 아니라 시각·환경 데이터 등도 AI가 인식하고 이해해 사람과 유사한 반응을 내놓을 수 있다. 단순히 명령을 따른 것을 넘어서 사용자 착장을 인식하고 분석해 목적에 맞는 의상을 추천해주는 식이다. 김용재 삼성전자 영상디스플레이사업부 부사장은 “볼리에 삼성 AI와 제미나이의 강력한 멀티모달 추론 기능을 결합해 사용자의 요구를 예측하며 상호작용하는 맞춤형 AI 동반자의 시대를 열겠다”고 말했다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

beherenow@sedaily.com

beherenow@sedaily.com