하늘을 나는 드론이 연합해 적을 포위하거나, 여러 로봇이 함께 일하는 스마트 공장 기술은 개별 드론, 로봇에 탑재된 인공지능(AI) 에이전트 간의 협동이 필수다. 악천후나 센서가 고장 나는 상황에서는 이 협력 구조가 쉽게 무너질 수 있는데, 강한 위기를 만들고 이를 ‘예습’시켜 실전에서도 견고한 협력 체계 유지하는 기술 나왔다.

울산과학기술원(UNIST) 인공지능대학원 한승열 교수팀은 다중 에이전트 협력 구조를 단계적으로 무너뜨리는 인위적 오작동 공격 전략인 ‘늑대 떼 공격(Wolfpack Attack)’과 이를 학습에 활용하는 방어 프레임워크 ‘WALL’을 함께 개발했다고 30일 밝혔다.

강화학습은 AI가 다양한 상황을 경험하며 스스로 행동 전략을 익히는 학습 방식이다. 여러 AI 에이전트가 협력하는 다중 에이전트 강화학습(MARL, Multi-Agent Reinforcement Learning)에서는, 한 에이전트에 문제가 생겨도 나머지가 이를 보완해 전체 성능을 유지한다. 이 때문에 단일 에이전트를 무작위로 교란하는 기존 공격 방식만으로는 협력 체계의 취약점을 제대로 평가하기 어렵고, 센서 고장, 날씨 변화, 의도적 해킹과 같은 현실적 위기 상황에 대한 훈련 효과도 제한적이다.

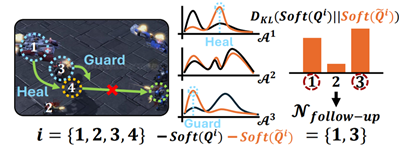

연구팀이 개발한 ‘Wolfpack Attack’은 먼저 한 에이전트를 오작동시킨 뒤 그를 도우려는 나머지 에이전트에 연쇄적으로 문제를 일으켜 전체 협력 구조를 붕괴시키는 방식이다. 늑대가 떼를 이뤄 약한 개체를 고립시킨 뒤, 이를 도우러 오는 동료 개체까지 순차적으로 제압하는 사냥 방식을 모방한 전략이다.

이 공격 모델에서는 트랜스포머 기반 예측 모델이 향후 손실을 계산해 첫 공격 시점을 자동으로 선택하고, 후속 공격 대상은 협동성에 민감하게 반응하는 에이전트를 행동 변화량으로 분석해 차례로 결정한다.

제1저자인 이선우 연구원은 “이전에는 정해진 상황에서 AI가 얼마나 잘 작동하는지를 점검하는 정도였지만, 이 공격 전략은 실제처럼 상황이 계속 바뀌고 예측하기 어려운 위기 상황을 만들어 AI가 그 안에서 얼마나 잘 대응하는지를 평가할 수 있다”라고 설명했다.

함께 개발된 WALL(Wolfpack-Adversarial Learning for MARL)은 이러한 교란 전략을 AI 훈련 환경에 도입한 방어 학습 구조다. 실험 결과, WALL을 통해 학습한 AI는 위치 오류나 통신 지연 같은 상황에서도 서로 부딪히지 않고 목표 지점에 도달하거나, 함께 물체를 밀고 진형을 유지하는 등 높은 적응력과 안정적인 협력 성능을 보였다.

한승열 교수는 “이번에 개발된 기술은 협력형 AI 모델의 정확한 성능 평가와 위기 상황에 강한 협력 AI모델을 만드는 데 활용될 수 있다”며 “자율 드론, 스마트 팩토리, 군사·재난 현장의 군집 로봇 산업 발전에 기여할 수 있을 것”이라고 설명했다.

이번 연구는 과기정통부와 정보통신기획평가원(IITP)의 ‘지역 지능화 혁신 인재 양성사업’ 및 ‘사람 중심 인공지능 핵심 원천기술 개발’과 ‘인공지능대학원 지원(울산과학기술원)’사업의 도움을 받아 이뤄졌다.

연구 결과는 기계학습 분야의 최고 권위 학회인 ICML(International Conference on Machine Learning)에 채택됐다. 7월 13일부터 19일까지 캐나다 밴쿠버에서 열린 2025 ICML에는 전 세계에서 약 1만 2107편의 논문이 투고됐으며, 이 중 3260편만이 채택됐다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

jjs@sedaily.com

jjs@sedaily.com